- NGCから学習済みモデルをダウンロードする方法

- 顔検出モデル(FaceDetect)の動かし方

NGC(NVIDIA GPU CLOUD)で提供されているTLT(Transfer Learning Toolkit)の学習済みモデルを使ってみました。

今回はFaceDetectモデルを使って人の顔を検出しています。

以下環境で動作確認を行いました。

TLTの環境構築手順は以下の記事にまとまっています。

FaceDetectモデルの概要

FaceDetectモデルは人の顔を検出するように事前学習されたDeepLeraningのモデルで、NGC(NVIDIA GPU CLOUD)からダウンロードすることができます。

モデルの概要は以下の通りです。

| モデルタイプ | 検出型 |

| ラベル | 1クラス

|

| 入力 | 736 X 416 X 3 |

| 出力 | 顔をバウンディングボックスで囲む |

| モデルの構造 | NVIDIADetectNet_v2 ResNet18 |

| モデルロードキー | nvidia_tlt |

ディレクトリ構成

以下のディレクトリ構成で推論を行いました。

facenet/ ├ infer_trained_model_facenet.ipynb # 実行するソースコード ├ data/ # $DATA_DOWNLOAD_DIR ├ specs/ # $SPECS_DIR │ ├ facedetect_inference_tlt.txt # 推論に関する設定ファイル ├ tlt-experiments/ # $USER_EXPERIMENT_DIR │ ├ pretrained_facedetect # 学習済みモデル │ ├ tlt_infer_facedetect # 推論結果出力先

推論用のコンフィグファイルを作成

TLTでの推論にはコンフィグファイルが必要になるので、予め作っておきましょう。

今回作ったファイル(facedetect_inference_tlt.txt)はこちらです。

inferencer_config{

# defining target class names for the experiment.

# Note: This must be mentioned in order of the networks classes.

target_classes: "face"

# Inference dimensions.

image_width: 1248

image_height: 384

# Must match what the model was trained for.

image_channels: 3

batch_size: 16

gpu_index: 0

# model handler config

tlt_config{

model: "/workspace/tlt-experiments/detectnet_v2/pretrained_facedetect/tlt_facenet_vtrainable_v1.0/model.tlt"

}

}

bbox_handler_config{

kitti_dump: true

disable_overlay: false

overlay_linewidth: 2

classwise_bbox_handler_config{

key:"face"

value: {

confidence_model: "aggregate_cov"

output_map: "face"

confidence_threshold: 0.8

bbox_color{

R: 0

G: 255

B: 0

}

clustering_config{

coverage_threshold: 0.00

dbscan_eps: 0.3

dbscan_min_samples: 0.05

minimum_bounding_box_height: 4

}

}

}

}

各パラメータの意味については以下の記事にまとめてあります。

顔検出をやってみる

それではFaceDetectモデルを使って顔検出をしてみましょう。

環境変数の設定

まずは環境変数を設定をします。

%env KEY=nvidia_tlt

%env USER_EXPERIMENT_DIR=/workspace/work/git/DeepLearning/tlt/facenet/tlt-experiments

%env DATA_DOWNLOAD_DIR=/workspace/work/git/DeepLearning/tlt/facenet/data

%env SPECS_DIR=/workspace/work/git/DeepLearning/tlt/facenet/specs

%env NUM_GPUS=1

変数はそれぞれ以下の意味を持ちます。

- KEY : モデルロードキー

- USER_EXPERIMENT_DIR : 生成ファイルの出力先

- DATA_DOWNLOAD_DIR : 画像データの配置場所

- SPECS_DIR : 設定ファイルの配置場所

モデルをダウンロードする

学習済みモデルのfacenetをダウンロードします。

まずはtltのモデル一覧を表示します。

# ダウンロードできるモデルの一覧を表示

!ngc registry model list nvidia/tlt_*

facenetを見つけたので、モデルのバージョン一覧を表示します。

# ダウンロードできるモデルのバージョン一覧を表示

!ngc registry model list nvidia/tlt_facenet:*

ダウンロード先のディレクトリを作成しておきます。

# 学習済みモデルのダウンロード先を作成

!mkdir -p $USER_EXPERIMENT_DIR/pretrained_facedetect/

モデルをダウンロードします。

# NGCから学習済みモデルをダウンロード

!ngc registry model download-version nvidia/tlt_facenet:trainable_v1.0 \

--dest $USER_EXPERIMENT_DIR/pretrained_facedetect/

モデルがちゃんとダウンロードできていることを確認しましょう。

# ダウンロードしたモデルの確認

!ls -rlt $USER_EXPERIMENT_DIR/pretrained_facedetect/

!ls -rlt $USER_EXPERIMENT_DIR/pretrained_facedetect/tlt_facenet_vtrainable_v1.0

tlt_facenet_vtrainable_v1.0ディレクトリ配下にmodel.tltがダウンロードできていることが確認できました。

total 4 drwx------ 2 root root 4096 Mar 1 14:45 tlt_facenet_vtrainable_v1.0 total 45364 -rw------- 1 root root 46450184 Mar 1 14:45 model.tlt

推論の実行

推論したい画像ファイルを $DATA_DOWNLOAD_DIR/の中に入れておきましょう。

まずはテストデータを確認します。

# テストデータの確認

! ls $DATA_DOWNLOAD_DIR/

テストデータがあることを確認したら、いよいよ推論です。

# 推論の実行

!tlt-infer detectnet_v2 -e $SPECS_DIR/facedetect_inference_tlt.txt \

-o $USER_EXPERIMENT_DIR/tlt_infer_facedetect \

-i $DATA_DOWNLOAD_DIR/ \

-k $KEY推論が完了したらImference completeと表示されます。

[INFO] iva.detectnet_v2.scripts.inference: Inference complete

出力結果は2種類作成されます。

- images_annotated : 検出枠のついた画像

- labels : 検出枠の座標データ

ちゃんとファイルが作られていることを確認します。

# 出力の確認

!ls $USER_EXPERIMENT_DIR/tlt_infer_facedetect

!ls $USER_EXPERIMENT_DIR/tlt_infer_facedetect/images_annotated

検出枠が正しく表示されていることも確認しておきましょう。

まずは指定した画像を表示する関数を作成します。

# Simple grid visualizer

%matplotlib inline

import matplotlib.pyplot as plt

import os

from math import ceil

valid_image_ext = ['.jpg', '.png', '.jpeg', '.ppm']

def visualize_images(image_dir, num_cols=4, num_images=10):

output_path = os.path.join(os.environ['USER_EXPERIMENT_DIR'], image_dir)

num_rows = int(ceil(float(num_images) / float(num_cols)))

f, axarr = plt.subplots(num_rows, num_cols, figsize=[80,40])

f.tight_layout()

a = [os.path.join(output_path, image) for image in os.listdir(output_path)

if os.path.splitext(image)[1].lower() in valid_image_ext]

for idx, img_path in enumerate(a[:num_images]):

col_id = idx % num_cols

row_id = idx // num_cols

img = plt.imread(img_path)

axarr[row_id, col_id].imshow(img)

検出結果を12枚表示してみます。

OUTPUT_PATH = 'tlt_infer_testing/images_annotated' # relative path from $USER_EXPERIMENT_DIR.

COLS = 3 # number of columns in the visualizer grid.

IMAGES = 12 # number of images to visualize.

visualize_images(OUTPUT_PATH, num_cols=COLS, num_images=IMAGES)

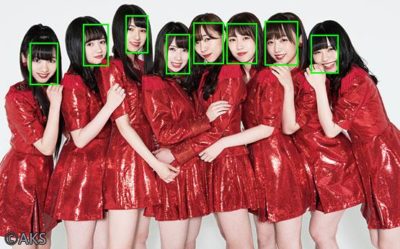

今回はアイドルの写真をテストデータとして使用しましたがちゃんと検出できているようでした。

まとめ

NGC(NVIDIA GPU CLOUD)で提供されている学習済みの顔検出モデルを使ってみました。

顔検出のような汎用的なタスクは、自分で作成するよりもすでに企業が作ったモデルを利用したほうが良い精度が得られると思います。

提供されているモデルはある程度の精度は担保されていて、動かすだけなのでとりあえずAIを動かしてみたい人には便利ですね。

あらゆる企業から学習済みモデルは沢山公開されているので、ぜひ使ってみてください。

コメント